混合精度训练能提升算力服务器效率吗?

发布日期:

2025-02-11 13:24:55

本文链接

https://www.idcsp.com//help/2320.html

本文关键词

混合精度训练确实能够显著提升算力服务器的效率,主要体现在以下几个方面:

1. 提升计算速度

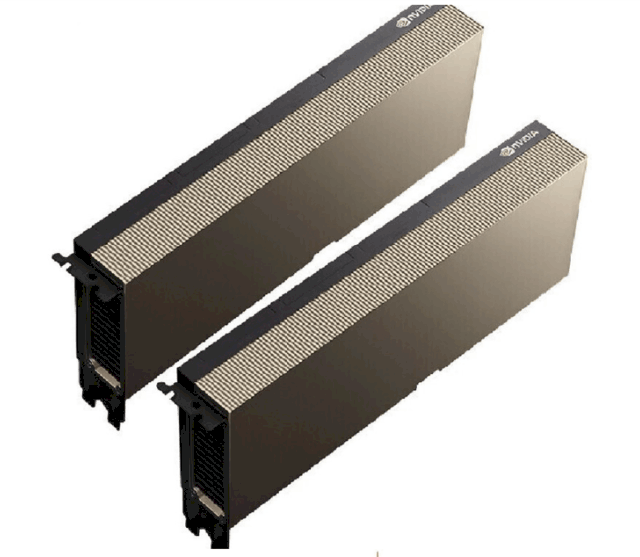

混合精度训练通过结合低精度(如 FP16)和高精度(如 FP32)计算,利用现代 GPU(如 NVIDIA 的 Volta、Turing 和 Ampere 架构)对低精度计算的优化,显著加速训练过程。例如,使用混合精度训练时,训练速度可以提升数倍。

2. 减少显存占用

低精度数据(如 FP16)占用的显存空间仅为高精度数据(如 FP32)的一半,这意味着在相同的显存容量下,可以处理更大的模型或更大的批量数据。例如,混合精度训练可以将显存占用减少一半。

3. 提高模型性能

混合精度训练不仅能够提升训练速度和减少显存占用,还能在某些情况下提高模型的最终性能。低精度计算引入的噪声可以作为一种正则化手段,有助于模型的泛化。

4. 精度稳定性

通过在关键操作中保留高精度(如 FP32),混合精度训练可以在保持低精度计算优势的同时,避免因精度不足导致的数值不稳定。例如,在梯度更新时,将低精度梯度转换为高精度,可以有效避免梯度下溢。

5. 硬件资源的高效利用

混合精度训练能够更好地利用 GPU 的硬件特性,如 Tensor Core,进一步提升计算效率。例如,A100 GPU 在混合精度训练中的性能是前一代 V100 GPU 的 2.5 倍。

实现方法

在 PyTorch 中,可以使用 torch.cuda.amp 模块来实现混合精度训练。通过 autocast 上下文自动管理数据类型转换,并使用 GradScaler 来避免梯度下溢。例如:

Python

复制

from torch.cuda.amp import autocast, GradScaler

scaler = GradScaler()

with autocast():

outputs = model(inputs)

loss = criterion(outputs, targets)

scaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()

总结

混合精度训练能够在不显著影响模型精度的前提下,显著提升算力服务器的计算效率和资源利用率。它不仅加快了训练速度,还减少了显存占用,同时通过合理的精度管理,保持了模型的数值稳定性和最终性能。

服务器租用入口:https://www.idcsp.com/gpu/

服务器租用官方电话:400-028-0032

优选机房

注册有礼

注册有礼

在线咨询

在线咨询

咨询热线:400-028-0032

咨询热线:400-028-0032