ChatGPT崩了?全球范围的宕机

发布日期:

2024-12-13 10:52:06

本文链接

https://www.idcsp.com//industry/2124.html

本文关键词

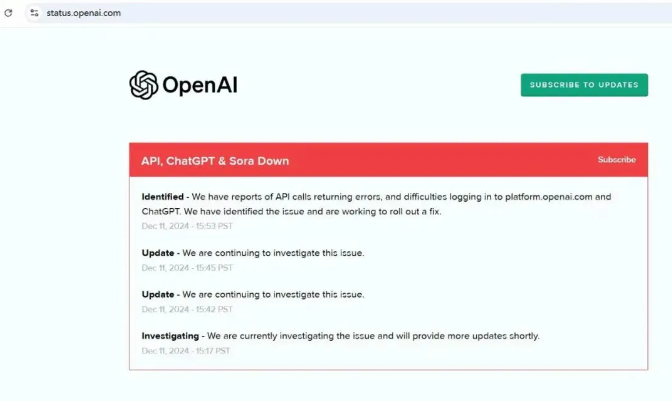

今天(12月12日)上午,OpenAI证实其聊天机器人ChatGPT正经历全球范围的宕机,ChatGPT、Sora及API仍处于瘫痪状态。

OpenAI更新事故报告称,API、ChatGPT和Sora服务现已全面恢复运行。 今日稍早时候,OpenAI证实其聊天机器人ChatGPT经历全球范围宕机,Sora及API也受到影响。据了解,此次故障持续约4小时10分钟。OpenAI表示,将对此次故障进行全面的根本原因分析。 提到ChatGPT宕机,大家可能首先想到的是它的服务器,它所需要的GPU,需要的算力。 那我们来估算下ChatGPT这类大模型到底要消耗多少GPU? 要知道,ChatGPT这类大模型有两面,一方面是模型训练,另一方面是模型推理应用,做起来很受算力困扰。 大模型的训练需要几亿打底,想将大模型进行规模化应用,比如支撑成百上千万用户的频繁使用,那需要的算力成本至少得百亿量级。 测算一下,要支撑足够的用户量和业务规模,到底需要多少算力(尤其是GPU)。 -训练这类模型所需的算力取决于:模型的规模(参数数量)、训练数据集的大小、训练轮次、批次大小。 -FLOPs(浮点运算次数):执行某个任务所需的计算量。 参考GPT-3中最大的模型(1750亿参数)的训练大约需要3.14 * 10^23次浮点运算(FLOPs)得出: 一个千亿大模型所需FLOPs = (千亿参数 / 1750亿参数) * 3.14 * 10^23 FLOPs=1.8 * 10^23 FLOPs 以英伟达A100 GPU为例,其具有每秒19.5万亿次(19.5 TFLOPs)的浮点运算能力 所需GPU数量 = 1.8 * 10^23 FLOPs / (19.5 * 10^12 FLOPs/s * 训练时间秒数) 如果希望在10天(约864000秒)内完成训练,可以按照以下计算方式得到所需GPU数量: 所需GPU数量 = 1.8 * 10^23 FLOPs / (19.5 * 10^12 FLOPs/s * 864000s) 得出,想要在10天内训练1000亿参数规模、1PB训练数据集,大约需要10830个英伟达A100 GPU。 假设每个A100 GPU的成本约为10000美元,那么10830个GPU的总成本约为: 10830 * $10,000 = $108,300,000 正是因为GPU强大的计算能力,大模型得以茁壮成长,从浅层神经网络发展到深度学习的复杂模型,从局限的应用领域扩展至无所不及的智能场景。 但一般情况下,中小企业和个人很少需要用到这么多的GPU,也不需要花这么多的成本,又要避免算力资源浪费那应该怎么办呢? 极云科技旗下品牌“极智算”,提供各种类型和规格的算力租用。

在这里,用户可以根据自己的实际需求灵活选择,既方便又省钱!后续还会有更多GPU产品持续更新... 新用户认证更有千元优惠券可领取! 更多算力详情尽在:https://www.jygpu.com 互联网基础服务 当然选极云! 扫码即可为您提供 定制化解决方案! 关于我们 极云科技作为一家位于中国西南地区的高新技术企业,专注于为各行各业提供全面的信息技术解决方案。公司凭借深厚的技术积累和创新能力,已成为IDC、云计算及IT信息化服务领域的领先供应商。业务涵盖IDC(互联网数据中心)服务、云计算服务、IT信息化、AI算力租赁平台(智算云)。 极云科技秉承“守信、创新、协作、共赢”的企业精神,致力于成为客户最值得信赖的互联网基础服务提供商。

优选机房

注册有礼

注册有礼

在线咨询

在线咨询

咨询热线:400-028-0032

咨询热线:400-028-0032